Xem nhanh

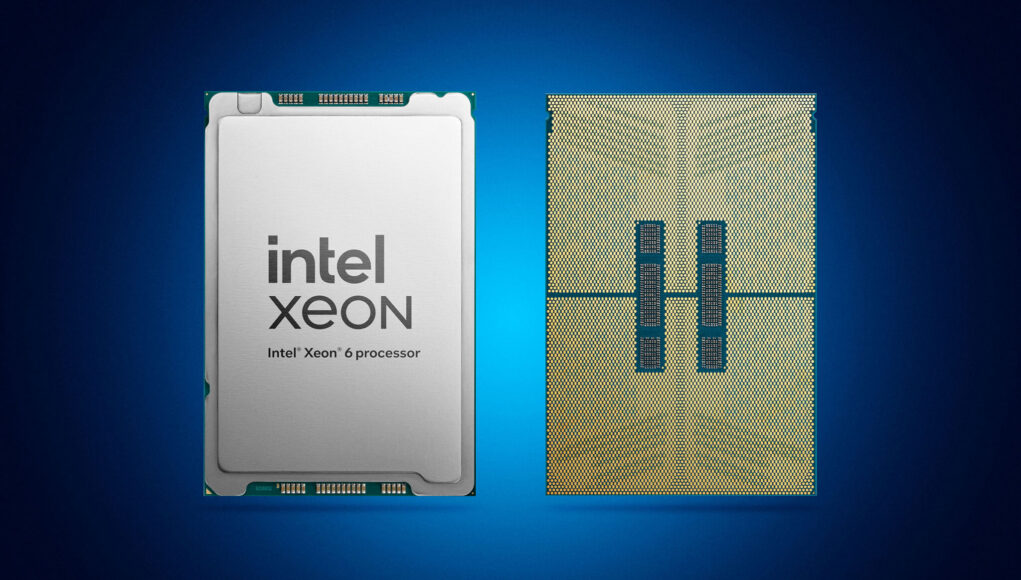

Intel trình làng vi xử lý Xeon 6 với các nhân hiệu năng cao (Performance-core, viết tắt là P-core), qua đó tăng hiệu năng xử lý các ứng dụng AI và HPC nhanh hơn gấp bội.

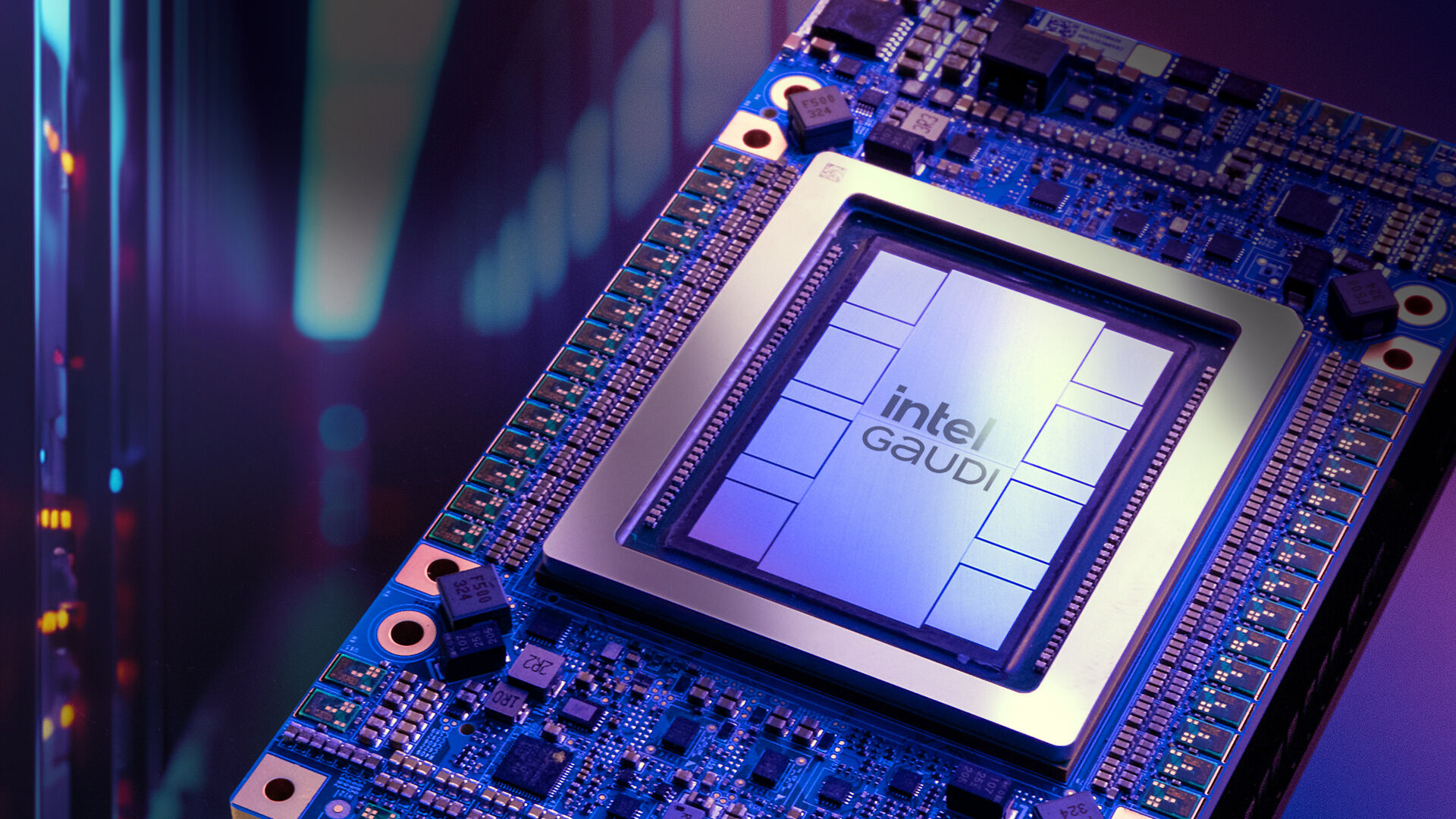

Trong bối cảnh AI tiếp tục tạo nên những thay đổi sâu rộng trong nhiều lĩnh vực, các doanh nghiệp ngày càng cần đến cơ sở hạ tầng vừa hiệu quả về chi phí, vừa có thể phát triển và triển khai nhanh chóng. Để đáp ứng nhu cầu này, Intel chính thức giới thiệu Xeon 6 với các nhân hiệu năng cao và bộ tăng tốc AI Gaudi 3. Hai sản phẩm này củng cố thêm cam kết của Intel trong việc cung cấp các hệ thống AI mạnh mẽ với hiệu năng trên mỗi watt điện được tối ưu và tổng chi phí sở hữu (TCO) thấp hơn.

Ông Justin Hotard, Phó Chủ tịch Điều hành kiêm Tổng Giám đốc Nhóm Trung tâm Dữ liệu và Trí tuệ Nhân Tạo tại Intel, chia sẻ: “Nhu cầu ngày càng lớn về AI dẫn đến một sự chuyển đổi lớn trong lĩnh vực trung tâm dữ liệu. Ngành công nghệ đang đòi hỏi có nhiều lựa chọn hơn về phần cứng, phần mềm và các công cụ phát triển. Với Xeon 6 tích hợp P-core và bộ tăng tốc AI Gaudi 3, Intel đang hỗ trợ một hệ sinh thái mở để các doanh nghiệp có thể triển khai mọi ứng dụng tốt hơn, cả về hiệu năng xử lý, khả năng sử dụng điện, và tính bảo mật.”

Intel Xeon 6 với P-core và bộ tăng tốc AI Gaudi 3

Intel mang đến những cải tiến mới về công nghệ cho cơ sở hạ tầng AI thông qua hai sản phẩm mới trong danh mục trung tâm dữ liệu:

- Intel Xeon 6 với P-core: Được thiết kế để chạy các ứng dụng đòi hỏi sức mạnh tính toán cao với hiệu quả sử dụng điện vượt trội, Xeon 6 mang đến hiệu năng gấp đôi so với thế hệ tiền nhiệm. Dòng vi xử lý mới của Intel có số lượng nhân nhiều hơn, băng thông bộ nhớ gấp đôi và khả năng tăng tốc AI được tích hợp trong mọi nhân. Bộ vi xử lý này được thiết kế để đáp ứng các yêu cầu về hiệu năng của AI từ các thiết bị vùng biên đến trung tâm dữ liệu và môi trường đám mây. Thông qua mối quan hệ hợp tác chiến lược với Intel, Google Cloud có thể cung cấp giải pháp với hiệu năng và sự linh hoạt theo nhu cầu của doanh nghiệp, bao gồm cả những giải pháp tích hợp Intel Xeon 6 với P-core trong tương lai.

- Bộ tăng tốc AI Intel Gaudi 3: Được tối ưu hóa cho các mô hình generative AI (Gen AI) quy mô lớn, Gaudi 3 trang bị 64 nhân xử lý Tensor (TPC) và 8 công cụ nhân ma trận (matrix multiplication engine, viết tắt là MME) để tăng tốc khả năng tính toán của mạng thần kinh nhân tạo (deep neural network). Bộ tăng tốc AI của Intel bao gồm bộ nhớ HBM2e 128 gigabyte (GB) cho việc huấn luyện và suy luận, và 24 cổng Ethernet 200 Gigabit (Gb) cho khả năng mở rộng mạng. Gaudi 3 cũng cung cấp khả năng tương thích mượt mà với framework PyTorch và các mô hình transformer và diffuser tiên tiến từ Hugging Face. IBM và Intel đang hợp tác để cung cấp dịch vụ Gaudi 3 nhằm hỗ trợ khách hàng tận dụng tốt sức mạnh của AI. Thông qua sự hợp tác này, Intel và IBM đặt mục tiêu giảm tổng chi phí sở hữu để tận dụng và mở rộng quy mô AI, đồng thời nâng cao hiệu năng xử lý.

Tăng cường các hệ thống AI với nhiều lợi ích từ tổng chi phí sở hữu

Việc triển khai AI trên quy mô lớn đòi hỏi doanh nghiệp phải cân nhắc đến nhiều yếu tố, như các tùy chọn triển khai có đủ linh hoạt để đáp ứng nhu cầu, tỉ lệ hiệu năng trên giá thành có thực sự cạnh tranh, và các công nghệ AI có thể sử dụng được.

Hạ tầng x86 mạnh mẽ và hệ sinh thái mã nguồn mở rộng lớn của Intel hỗ trợ các doanh nghiệp xây dựng các hệ thống AI mang lại giá trị cao với tổng chi phí sở hữu và hiệu năng trên mỗi watt điện được tối ưu. Đáng chú ý, 73% các máy chủ tăng tốc bằng GPU đều sử dụng Intel Xeon làm CPU chính.

Intel hợp tác với các OEM hàng đầu bao gồm Dell Technologies và Supermicro để đồng thiết kế các hệ thống phù hợp với nhiều nhu cầu cụ thể của khách hàng nhằm triển khai AI hiệu quả.

Thu hẹp khoảng cách từ nguyên mẫu cho đến thành phẩm qua các nỗ lực hợp tác đồng thiết kế

Chuyển đổi các giải pháp Gen AI từ nguyên mẫu sang hệ thống sẵn sàng sản xuất đặt ra những thách thức về giám sát thời gian thực, xử lý lỗi, ghi nhật ký, bảo mật và khả năng mở rộng. Intel giải quyết những thách thức này thông qua nỗ lực hợp tác đồng thiết kế với các OEM và đối tác để cung cấp các giải pháp tạo sinh tăng cường truy xuất (retrieval-augmented generation, viết tắt là RAG) ổn định và đáng tin cậy, sẵn sàng cho việc sản xuất.

Được xây dựng trên Nền tảng Mở dành cho AI cấp Doanh nghiệp (Open Platform for Enterprise AI, viết tắt là OPEA), các giải pháp này tích hợp các dịch vụ con dựa trên OPEA vào một hệ thống RAG có khả năng mở rộng, được tối ưu hóa cho các hệ thống AI chạy Xeon và Gaudi. Hệ thống này được thiết kế để cho phép doanh nghiệp dễ dàng tích hợp các ứng dụng từ Kubernetes, Red Hat OpenShift AI, và Red Hat Enterprise Linux AI.

Mở rộng khả năng truy xuất các ứng dụng AI cấp doanh nghiệp

Danh mục Tiber của Intel cung cấp các giải pháp giúp doanh nghiệp giải quyết các thách thức như khả năng truy cập, chi phí, độ phức tạp, bảo mật, tiết kiệm điện năng, và khả năng mở rộng trên các môi trường AI, điện toán đám mây và thiết bị vùng biên. Intel Tiber Developer Cloud hiện cung cấp các hệ thống xem trước của Intel Xeon 6 để doanh nghiệp có thể đánh giá và thử nghiệm công nghệ.

Ngoài ra, một số khách hàng sẽ được tiếp cận Intel Gaudi 3 sớm để xác thực các phương án triển khai mô hình AI khi các cụm Gaudi 3 sẽ bắt đầu được triển khai trong quý tới cho quá trình sản xuất trên quy mô lớn.

Nhiều dịch vụ mới sẽ được ra mắt, nổi bật có SeekrFlow, một nền tảng AI đầu cuối từ Seekr để phát triển các ứng dụng AI đáng tin cậy. Các bản cập nhật phần mềm mới nhất bao gồm bản mới nhất của Synpase, các notebook của Jupyter được cài sẵn PyTorch 2.4 và Intel oneAPI, cũng như các công cụ AI 202.2 với các tính năng tăng tốc AI mới và hỗ trợ các bộ vi xử lý Xeon 6.