Không còn được dùng cho mục đích giải trí, Kaspersky cho biết Deepfake đang dần bị các tội phạm mạng khai thác trở thành công cụ lừa đảo.

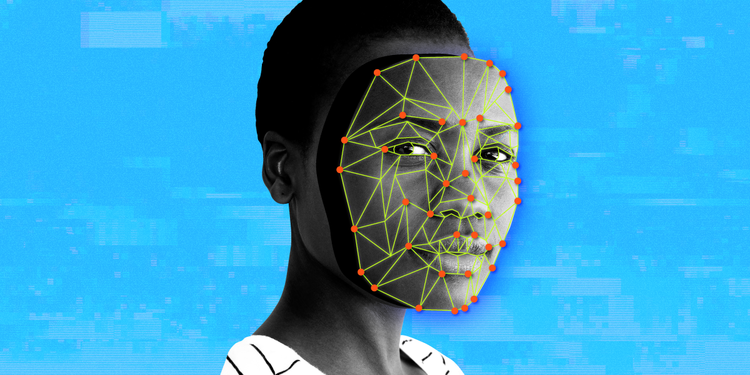

Trong bối cảnh các tiến bộ công nghệ liên tục định hình mạng xã hội và phương tiện truyền thông đại chúng, Deepfake đang trở thành mối quan ngại lớn khi số lượng những vụ lừa đảo bằng Deepfake ngày càng gia tăng. Sau khi nghiên cứu trên diễn đàn darknet (darknet forum), nơi các tội phạm công nghệ thường xuyên hoạt động, Kaspersky nhận định rằng có nhiều tội phạm sử dụng Deepfake để lừa đảo, đến mức nhu cầu sử dụng vượt xa nguồn cung các phần mềm Deepfake hiện có trên thị trường.

Khi cầu vượt cung, các chuyên gia của Kaspersky dự đoán rằng các vụ lừa đảo bằng Deepfake sẽ tăng cao với nhiều hình thức đa dạng và tinh vi hơn. Từ cung cấp một video mạo danh chất lượng cao với đầy đủ dịch vụ sản xuất cho đến việc sử dụng hình ảnh người nổi tiếng trong luồng phát trực tuyến giả mạo (fake livestream) trên mạng xã hội và hứa hẹn sẽ thanh toán gấp đôi số tiền nạn nhân đã gửi họ.

“Deepfake đã trở thành cơn ác mộng đối với phụ nữ và xã hội. Tội phạm mạng hiện đang khai thác trí tuệ nhân tạo (AI) để ghép khuôn mặt nạn nhân vào ảnh và video khiêu dâm cũng như trong chiến dịch tuyên truyền. Những hình thức này nhằm mục đích thao túng dư luận bằng cách phát tán thông tin sai lệch hoặc thậm chí gây tổn hại đến danh tiếng của tổ chức hoặc cá nhân. Chúng tôi kêu gọi công chúng nâng cao cảnh giác trước mối đe dọa này,” bà Võ Dương Tú Diễm, Giám đốc khu vực Việt Nam của Kaspersky chia sẻ.

Theo Regula, một hệ thống tham chiếu thông tin, có tới 37% doanh nghiệp trên toàn thế giới va chạm các vụ lừa đảo Deepfake bằng giọng nói và 29% trở thành nạn nhân của video Deepfake. Deepfake đã trở thành mối đe dọa đối với an ninh mạng Việt Nam, nơi tội phạm mạng thường sử dụng các cuộc gọi video deepfake để mạo danh một cá nhân và vay mượn người thân, bạn bè của họ những khoản tiền lớn cho những trường hợp cấp bách. Hơn nữa, một cuộc gọi điện video deepfake có thể được thực hiện chỉ trong vòng một phút nên nạn nhân rất khó phân biệt giữa cuộc gọi thật và giả.

Mặc dù AI đang bị các tội phạm lạm dụng cho những mục đích xấu, các cá nhân và doanh nghiệp vẫn có thể tận dụng AI để nhận diện Deepfake nhằm giảm thiểu xác suất thành công của các vụ lừa đảo.

Kaspersky chia sẻ các giải pháp để người dùng tự bảo vệ mình khỏi các trò lừa đảo Deepfake:

- Công cụ phát hiện nội dung AI: Những phần mềm phát hiện nội dung do AI tạo ra sử dụng thuật toán AI tiên tiến để phân tích và xác định mức độ bị chỉnh sửa của tệp hình ảnh, video, âm thanh. Đối với video Deepfake, một số công cụ giúp nhận diện sự chuyển động không khớp giữa khuôn miệng và lời thoại. Một số công cụ phát hiện lưu lượng máu bất thường dưới da bằng cách phân tích độ phân giải của video vì khi tim bơm máu, tĩnh mạch của con người sẽ đổi màu.

- Nội dung AI được đánh dấu watermark: Hình mờ (watermark) đóng vai trò là dấu hiệu nhận biết trong hình ảnh, video… giúp tác giả bảo vệ bản quyền cho các tác phẩm AI. Tuy nhiên, công cụ này có thể trở thành vũ khí chống lại Deepfake vì hình thức này có thể giúp truy tìm nguồn gốc của nền tảng tạo ra AI.

- Truy xuất nguồn gốc nội dung: Vì AI thu thập lượng lớn dữ liệu từ nhiều nguồn khác nhau để tạo nội dung mới, phương pháp này nhằm mục đích truy tìm nguồn gốc của nội dung đó.

- Xác thực video: là quá trình xác thực nội dung video không bị thay đổi so với giai đoạn đầu được tạo. Đây là quá trình được người sáng tạo video quan tâm nhất. Một số công nghệ mới nổi sử dụng thuật toán mã hóa để chèn các giá trị băm theo các khoảng thời gian đặt trong video. Nếu video đã qua chỉnh sửa, giá trị băm sẽ bị thay đổi.